人工智能将何去何从?听听人工智能或参与神经信息处理系统大会 (NIPS) 演示的开发者怎么说

人工智能将何去何从?这个问题最适合于在本周加州长滩市举行的神经信息处理系统大会(即人们更为熟知的 NIPS)的论坛和工作坊上抛出。

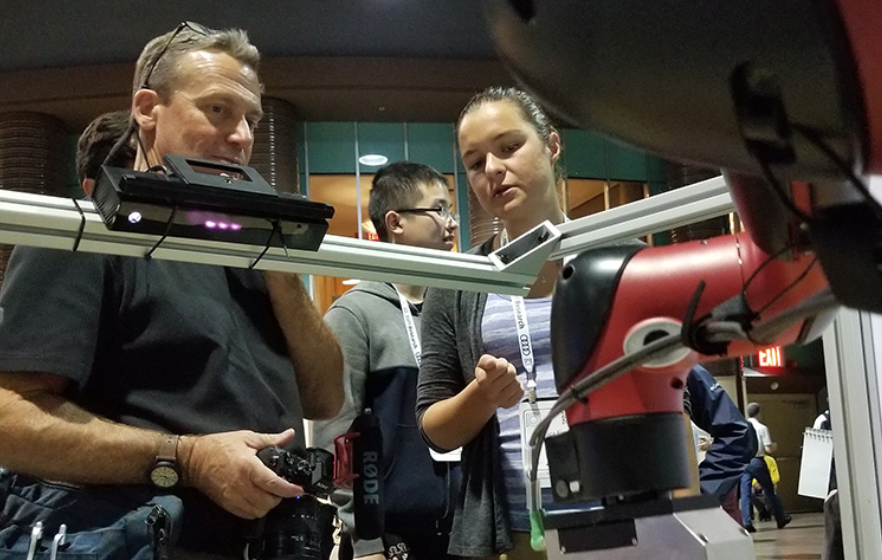

可能没有什么比直接向 MILABOT 提问更有趣了。这款人工智能产品由蒙特利尔大学的团队开发,并亮相于我们在此次大会展台举办的两场演示活动的其中一场。

这款机器人的特别之处在于:可以与用户进行开放式对话,能够从回复喵喵双关语到探究您与母亲的关系。

这款机器人的其中一位开发者 Iulian Vlad Serban,在邀请人工智能开发者上前对这款机器人进行测试时说:“有人居然与它聊了 20 到 30 分钟的个人生活。”

当问及人工智能的未来时,MILABOT 的回答也正是本周 7000 多名学生和开发者中的大部分人在长滩会议中心的走廊畅所欲言时所提及的。“这个问题我需要好好思考一下,”MILABOT 如是说。

正如 NIPS(全球顶级人工智能会议之一)的所有与会者一样,NVIDIA 也在致力于寻求这个问题的答案。

我们能够通过 NVIDIA 人工智能实验室为 Serban 这样的研发者提供研发支持,或我们通过 NVAIL 项目为 20 所顶尖高校和研究院提供研发支持,由公司内部工程师予以技术协助;我们也为学生提供相应支持,并开放 DGX 人工智能超级计算系统的访问权限。

观察和学习

一个答案:深度学习将帮助机器与现实世界,及现实世界中的人们更加顺畅地交互。

“我认为未来几年内将出现自主机器,”NVIDIA 首席执行官黄仁勋在我们的展台旁,与加州大学伯克利分校 (UC Berkeley) 的 Sergey Levine、Chelsea Finn 和 Frederik Ebert 交流各自的工作时这样说道。“你们正站在与现实世界交互的人工智能和机器的交汇点。”

来自伯克利分校的人工智能研究实验室 (BAIR) 的团队在 NIPS 上进行两场演示,展示全新的深度学习技术如何使这一切变为可能。

在 BAIR 的第一场演示中,您可以将汽车钥匙或一副眼镜等物品放在机器人的工作区。之后点击用户界面,为机器指明您要移动的物品在哪里,以及您希望它移至哪里。

随后机器人会根据其要进行的动作推想指定物品的移动位置,而用户可以通过预测视频观看这一推想过程。之后机器人将利用该预测规划其接下来的动作。

由于采用了创新型卷积神经网络设计,在上个月的一天,机器人的技能甚至令一些参与机器人训练的学生惊讶不已。

在第二场演示中,您可以通过引导机械手完成一项任务演示,例如将物品放入容器中。机器人将利用您的演示视频找到这个容器,并放入相同的物品。

与我们交流

在另一场演示中,MILABOT 吸引了 NIPS 的与会者,这些与会者大多是开发者,他们渴望找到难住聊天机器人的方法。

他们做到了,但除了一位开发者使用“代词消歧”进行误导之外,MILABOT 都可以保持对话顺利进行,甚至还可以使用牵强的双关语。

当被问到是否喜欢猫时,MILABOT 说:“我没有猫,但是如果我有一只的话,我应该会很喜欢它的喵喵。”(当然,“猫”是在人工智能开发者之间广泛流传的一个梗。)

这款聊天机器人由蒙特利尔学习算法研究院研发,为参加亚马逊 Alexa 大奖赛而设计。它所依托的会话模型并非仅有一个,而是多达 22 个。

至少从麻省理工学院的 Joseph Weizenbaum 在四十年前创造出能勉强回答人类提问的 ELIZA 开始,如何通过语音或文本与人类闲聊就成为计算机科学家努力克服的难题。

与 ELIZA 不同的是,MILABOT 依托的是创造者所说的模型“集成”。其中包括基于模板的模型、词袋 (bag-of-words) 模型、序列到序列 (sequence-to-sequence) 神经网络模型、隐变量神经网络模型以及来自最初的 ELIZA 的一个变体模型。

通过深度强化学习选择使用的模型至关重要。为了实现这一点,MILABOT 运用强化学习,其中软件代理通过执行一长串操作进行学习,使累计回报最大化。该强化学习应用与人类真实互动的众包数据。

它还不算完美,但是已足以吸引众人注意,使他们乐此不疲地向这个软件抛出一个又一个问题。