希捷存储系统行业及应用场景

目录

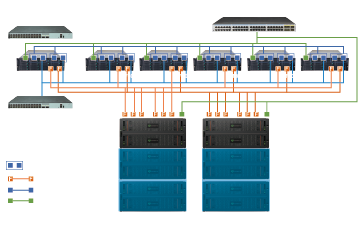

现代媒体工作流程对共享存储基础架构提出了重大挑战。

文件类型,编解码器,分辨率,比特率,压缩和未压缩媒体格式的激增,以及艺术家对即时访问和最小延迟的期望,使得传统的存储系统越来越难以满足工作的需求。

采用4K,8K和HDR(高动态范围)内容创作继续增加了单流带宽,从而对存储整体性能提出了更高的要求。同时,随着艺术家使用更广泛的硬件和软件平台来执行编辑、调色、渲染、特效、封装等任务,后期工作流程变得越来越复杂多样。

由此产生的工作负载,包括小块IO和大块数据流,随机访问和顺序文件的混合,使未经调整的现成存储解决方案难以胜任。在这些环境中,对高度可配置的模块化存储解决方案的需求变得越来越强,该解决方案采用经过优化的定制存储技术组合,可在整个后期处理过程中提供性能和可靠性。

存储的容量增长非常快。监控系统存储的容量=监控点数目×码流速率×保存时间,而监控点数目、码流速率和保存时间的迅速增长,必然会带动存储容量迅速增长。

稳定性要求高,要求在数据写入的时候不能丢失数据,特别对于一些法规要求的场景。

可扩展性要强。存储系统需要充分考虑后期监控范围扩大、画面质量提升、监控摄像头的增加,以及视频线路的增加带来的容量扩充和性能的扩展。

性能要求高。系统要求可以支持上千路的高清摄像头的数据存储,由于多路并发的高带宽要求,对存储系统性能提出了更高的要求。

合理的价格。如果价格太贵的话,存储容量巨大,整体解决方案成本过高会影响客户的投入。价格过高就不能满足大规模项目的需要。

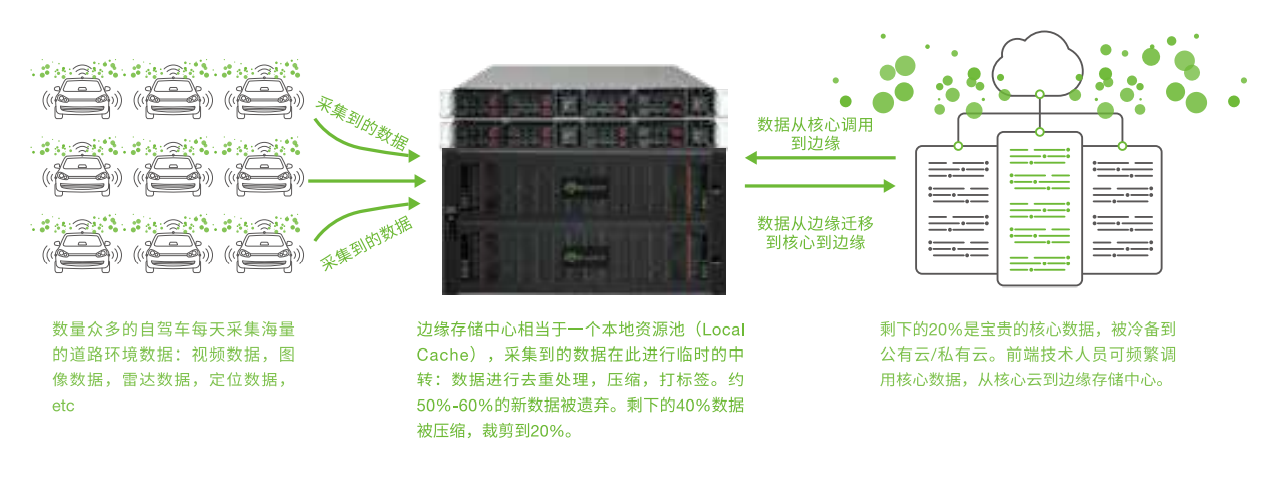

自动驾驶训练汽车每天都会通过车载传感器(激光雷达,摄像头,毫米波雷达等)采集4-10TB的数据,并储存在车载存储单元中。长期积累会达到几PB甚至几十PB的海量数据,这些数据对于自动驾驶算法训练与优化至关重要。

如果将海量的数据存储至公有云,在公有云中需要频繁地上载/下载某部分数据片段用于本地训练:

①带宽瓶颈凸显,速度会非常慢,导致效率降低;

②公有云上载/下载都需要计费,长此以往,会产生大量成本。

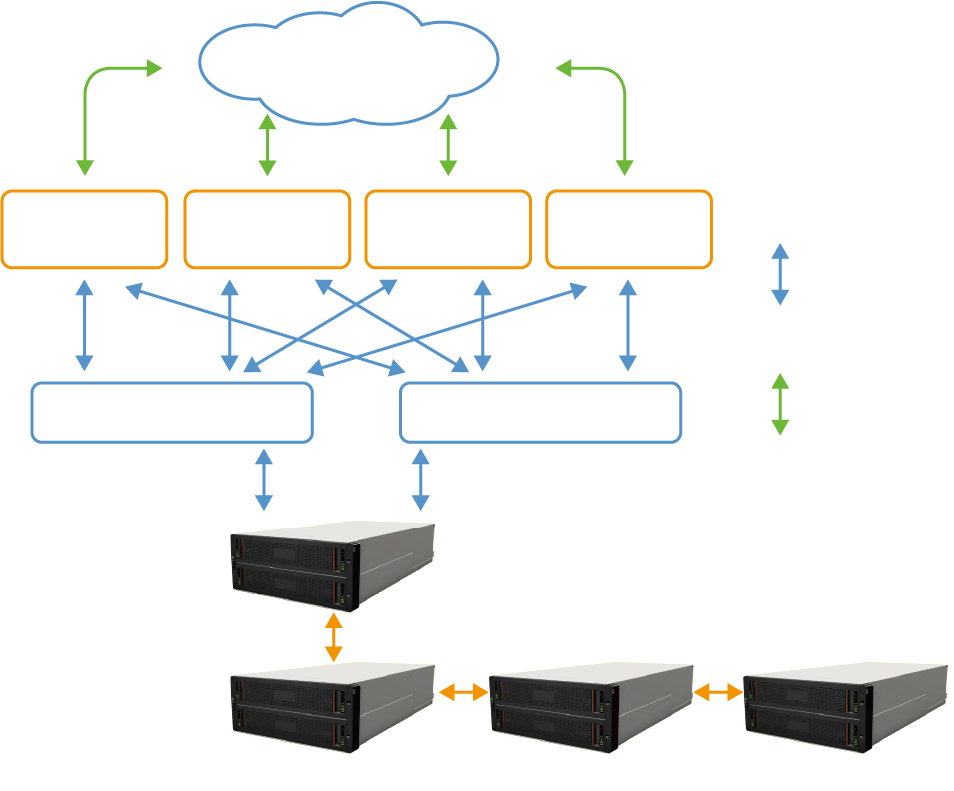

因此,许多自动驾驶科技公司寻求建立“PB级别私有云”,形成车队(端点采集)---私有云(边缘存储与训练)---公有云(核心数据冷备)的架构。提升本地开发的效率,降低数据存储与处理的成本。

希捷CORTX高性能对象存储系统,基于希捷Lyve Rack硬件平台和CORTX对象存储软件构成。

Lyve Rack凭借5U84或4U106的高密度的存储单元,提供PB级的可用空间作为边缘中心的存储系统,同时借助搭配的2节点服务器,以及CORTX对象存储软件,可以轻松实现对于海量对象数据的管理,客户可在上层搭建自己开发的软件算法,可针对采集回来的车载数据进行敏捷的处理。

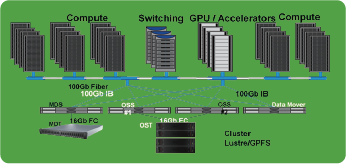

高性能计算(High performance computing,缩写HPC) 指通常使用很多处理器(作为单个机器的一部分)或者某一集群中的多台计算机(作为单个计算资源操作)的计算系统和环境。

HPC应用的主要领域是科学与工程计算,诸如高能物理、核爆炸模拟、气象预报、石油勘探、地震预报、地球模拟、药品研制、CAD设计中的仿真与建模、流体力学的计算等。

随着云计算和大数据技术的不断成熟和广泛应用,HPC已经渗透到HPDA和HPC Cloud领域。

有许多类型的HPC系统,不同的高性能计算应用具有不同的应用特征,相应的对于计算、网络和存储等方面有着不同的要求,应用于石油勘探、地震资料处理、气象、动漫渲染以及生命科学等领域的高性能计算系统,面对海量数据需要解决后端数据集中存取的I/O瓶颈。

以石油物探应用为例,地震资料处理数据的特点及对存储的要求主要体现在:

统一命名空间:不同的计算节点都要到这个统一命名空间中读取数据,存放、读取中间数据,存放结果数据;

数据量大:初始数据几十TB,中间数据是初始数据的10~20倍,但成果数据的大小却仅有初始数据的0.5~1%左右;

带宽要求高:计算节点和存储节点的数据交互次数不频繁,但是数据量大,即对网络带宽和存储节点的带宽要求高;

可靠性要求高:中间数据和结果数据都是珍贵数据,是通过大量的时间和资源的投入得出来的,所以对存储的可靠性要求高;

扩展性高:不同任务的计算集群,共用一个存储系统,避免数据迁移。

易用易管理:单一命名空间;存储资源可以灵活的划分给不同的计算任务(计算节点);维护简单;配额管理;

数据归档要求:中间数据和结果数据经过生命周期后,很少被访问,有归档需求。

高性能:能够提供稳定聚合带宽以及高速文件查询,大幅度减少计算任务的数据IO时间,提高集群的工作效率。通过增加IO节点和存储,带宽可线性增涨,满足大规模数据并行读写要求。

可扩展的海量存储空间:可在业务系统不间断的情况下,通过增加存储节点设备的方式扩展容量至PB级,使得高性能计算集群可以存放大量的计算素材和计算结果。

全局数据共享:提供单一系统映象,所有IO节点共享同一文件系统视图,使得所有计算节点能即时获取所需的数据,无需进行数据迁移,大幅度提高了集群的使用效率,支持负载均衡,单点故障容错。

目前对等传输网络的存储节点本身采用集中存储或分布式存储方案来实现;

由于对数据安全性和读写时效性的要求,存储更加趋于采购著名厂商的成熟产品。

集中存储因部署简单、RAID方式灵活,但扩展能力有限多应用于小规模集群,

而分布式存储因其扩展能力强,优化的文件系统性能则多用于大规模集群。

客户对存储方案的选择来自以下几个方面:

提高存储集群的密度,包括在单位空间内提升存储容量;

确保数据故障时重构效率的同时,提升可用容量的比率,降低每TB成本;

缩减每TB所需对应的计算、网络等配套硬件的成本;

实现集群可弹性伸缩,以应对市场波动可能带来的各种需求;

提高运维的自动化程度,实现故障自动转移,限制故障域尺寸。

快速部署:自动化部署、故障域隔离。

便捷运维:健康管理、容量预警、状态监控、恢复QoS、自动巡检、快速数据重构。

纵向扩容:业务无感知。

性能优化:无网络延时。

快速部署:自动化部署、故障域隔离、拓扑管理

便捷运维:健康管理、容量预警、状态监控、恢复QoS、自动巡检

整池扩容:业务无感知,无需数据重均衡,存储集群容量平滑扩展

可用率高:通过服务器对接JBOD 或Corvault数量调整,提供高可用空间

性能优化:针对IPFS 各阶段IO的访问特点,结合对象存储特性进行有针对性优化,大幅提升大规模存储集群在IPFS场景下性能

石油勘探是典型的HPC应用,在原理上通过反射地震波的形式完成对石油勘探,整个勘探过程大致分为反射波数据采集、地震资料处理和数据解释三个步骤。

石油地震数据处理系统是一个要求计算机系统运算性能、运行稳定性极高的计算环境。

其原因在于石油行业中的数据处理非常困难和庞大。

以找油和打井工作来说,一般采用三维地震勘探的办法是先在地面放炮,通过仪器测量地面震动反射波的情况,把采集所获得的地震波在地层中传播的运动学和动力学信息进行去伪存真处理,转化为地质信息,经过计算分析,反推出地下的生油、储油、盖层的地质构造特点,再确定在打井的具体位置。

勘探业务野外作业,经常是在大漠戈壁,或者是巨浪滔天的海上,物理环境十分恶劣,对存储系统的抗震、散热、容错等方面提出近乎苛刻的要求;

一般一次作业需要几个月的时间,每天的数据都有数十个TB,数以百计的数据采集传感器在短时间内并行持续地写入存储,对于存储的容量,带宽都有极高的要求;

野外作业不可能带着专业的IT人员,一旦发生设备故障会带来极大的经济损失。

自修复存储系统单机1.9PB SAS JBOD,

仅占用四个机架单元,整个机架中提供19PB,可通过并行文件系统无缝地平行扩展;

自修复存储系统提供高达36GB/秒的带宽,基于希捷的 Exos E 4U106机箱,

有106个3.5英寸硬盘托槽,支持18TB硬盘;

自修复存储系统有两个控制器,都基于第六代VelosCT品牌的希捷ASIC,

为数据保护和ADR(硬盘自主恢复)提供ADAPT品牌的擦除编码。

每个控制器都有 4 个 12Gbit/sec SAS 连接器,一个以太网接口用于管理访问管理。